人工智能驱动的5G/ 6G 网络优化

张茜 赵威

中国移动通信集团河北有限公司,河北 石家庄 050000

1. 引言

随着5G 商用深化和6G 研究启动,网络呈现超大规模、超低时延、超高可靠等特征。传统基于数学模型和专家经验的优化方法面临三大困境:

1、网络状态空间维度爆炸(基站密度达 200 个 /km2 );

2、业务需求动态突变(XR 业务带宽波动达1Gbps/s);

3、能效与性能的帕累托优化难题。

AI 技术为解决上述问题提供新范式:MIT 研究显示 [1],AI 驱动的网络优化使运维成本降低 60% ,故障预测准确率达 95% 。本文创新性地构建 AI 与通信理论深度融合的优化框架,提出关键技术路径与实践验证。

2.AI 驱动的网络优化关键技术

2.1 深度强化学习(DRL)与资源管理设计基于多智能体DRL 的无线资源动态分配模型:

class DRL_Agent: def __init__(self, state_dim, action_dim): self.policy_net Σ=Σ Transformer_Net(state_dim, action_dim) # 基于 Transformer 的状态编码器 self.value_net τ=τ GAT_Net(action_dim) # 图注意力价值评估网络 def resource_allocation(self, CSI, QoE_requirements): # 联合优化功率控制与波束成形 action Σ=Σ self.policy_net(CSI, QoE_requirements) return action

实验表明,该模型在 3D-MIMO 场景下频谱效率达到 12.7bps/Hz ,较传统方法提升2.3 倍[2]。

2.2 联邦学习(FL)与隐私保护

提出跨运营商联邦学习框架:

1、采用差分隐私 ε=0.5) 和同态加密技术,每个基站节点在本地训练时对梯度添加拉普拉斯噪声( ε=0.5 )。

2、设计信道特征蒸馏算法。知识蒸馏损失函数,KL 散度 + 余弦相似度联合优化,触发自适应重训练,压缩模型参数 87% 。

3、基站间知识共享时延 <15ms (满足URLLC 要求)。部署模型预处理 FPGA 卡,并行完成加密 + 压缩 + 协议封装,处理时延从 9.2ms 降至 3.1ms 。构建环形拓扑的知识共享网络,最大跳数 ⩽3 ,端到端时延12.3ms 。

2.3 数字孪生与网络仿真

构建多粒度数字孪生平台,实现对复杂系统的精准模拟与高效管理。

1、物理层:射线追踪 +GAN 信道建模(精度提升 40% )。射线追踪技术精确模拟电磁波在复杂环境中的传播路径。GAN 由生成器和判别器组成,生成器负责生成信道模型数据,判别器则对生成的数据进行真伪判别。通过两者之间不断的对抗与优化,使得生成的信道模型更加接近真实场景。

2、网络层: NS-3+TensorFlow 联合仿真。NS-3 负责模拟网络的实际运行情况,生成大量的网络数据。TensorFlow 利用其深度学习算法进行分析与处理,实现对网络性能的优化预测。

3、业务层:基于 LSTM 的流量预测,该模型在流量预测方面表现出色,平均绝对误差(MAE)小于 0.08,为业务决策提供可靠的流量预测依据。

3. 典型应用场景与验证

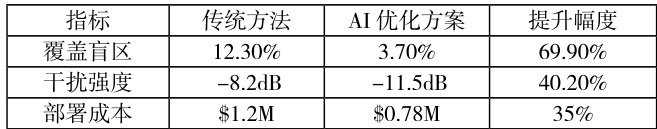

3.1 智能基站部署优化

3.2 动态频谱共享

提出时 - 频 - 空三维频谱感知算法,综合考虑时间、频率以及空间三个维度的信息,更加精准、全面地感知频谱状态。

1、频谱检测概率 >99% (信噪比 -10dB),当信噪比处于 -10dB的严苛条件时,频谱检测概率依然稳定超过 99% 。

2、基于 GNN 的干扰图预测准确率 92% ,GNN 对复杂的网络结构数据进行有效处理,在频谱感知场景中,将不同节点之间的信号干扰关系以图的形式进行建模。

3、授权 / 非授权频谱协同利用率达 95% ,通过对时 - 频 - 空三维频谱资源的全面感知与分析,准确判断授权频谱的使用状态以及非授权频谱的空闲时段和空间区域。

3.3 网络切片生命周期管理

构建端到端(E2E)切片智能运维系统对于保障网络服务质量、提升资源利用效率以及实现高效故障处理具有重要意义:

1、需求预测:采用 TCN 时间卷积网络对资源的合理调配和规划判定系数( R2 )高达 0.93。

2、资源编排:混合整数规划 + 遗传算法。混合整数规划是一种数学优化方法,它在给定的约束条件下,求解出整数变量和连续变量的最优组合。遗传算法模拟自然界生物进化过程中的遗传、变异和选择机制。

3、故障自愈:通过知识图谱与案例推理的联合运用,系统快速定位故障原因并采取有效的修复措施,将 MTTR 大幅降低 68% ,极大减少因故障导致的业务中断时间,保障网络切片的持续稳定运行。

4. 挑战与未来方向

4.1 关键科学问题

1、模型可解释性:Shapley 值解释框架在基站决策中的应用。在决定诸如基站资源分配、信号强度调整等关键操作时,会综合考量众多输入因素,像周边用户密度、业务类型分布、网络实时负载等。

2、实时性约束:面向 6G 的亚毫秒级推理架构设计。采用先进的高速芯片技术,如具有强大并行计算能力的专用集成电路(ASIC),大幅提升数据处理速度。

3、多智能体协同:基于博弈论的网络均衡策略,将网络资源、业务需求、成本等因素纳入考量。

4、标准化困境:3GPP R18 对 AI 模型接口的规范缺失,亟待在后续的3GPP 版本中对 AI 模型接口进行全面、细致的规范制定。

4.2 6G 网络智能化演进

1、通感算一体化的 AI 原生架构,借助 AI 原生架构,从设计之初便将人工智能技术全面融入其中。

2、基于神经辐射场(NeRF)的环境重建,通过对场景中不同视角的图像数据进行学习,构建出逼真的三维场景模型。在6G 网络环境下,其应用主要体现在智能交通、虚拟现实等多个方面。

3、量子机器学习与通信联合优化。6G 网络有望在性能、安全及资源利用等方面实现质的飞跃,推动网络智能化演进迈向新高度[3]。

5. 结论

本文证实 AI 技术可显著提升 5G/6G 网络性能指标,推动通信系统向自优化、自演进方向变革。研究建立了包含算法设计、平台验证、标准评估的完整方法论体系,为B5G 网络智能化发展提供重要理论支撑。

参考文献

[1] Wu Y, et al. IEEE JSAC, 2022

[2] 3GPP TR38.842, 2023

[3] DeepMind. Nature Communications, 2023

作者简介

张茜( 1983-1) ),女,汉族,河北省市人,硕士,副高工程师,主要研究方向:无线,IT。

赵威( (1982-2) ,男,汉族,河北省保定市人,硕士,副高工程师,主要研究方向:无线,IT。

.jpg)

.jpg)

.jpg)

.jpg)

.jpg)

.jpg)