基于Seflow机理的交通视觉场景流自监督建模与优化方法

赵家聪 魏丽娜

沈阳航空航天大学 民用航空学院 110136

中图分类号: 文献标志码: 文章编号:

1.引言

在国家政策大力支持自动驾驶产业发展、《国家综合立体交通网规划纲要》预测2025 年市场规模将达4,000 亿元的背景下,我国正积极推进“交通强国”与“新基建”战略,并以交通运输部《数字交通发展规划》中“提升重点路段全天候通行能力 20% ”为核心目标;然而,当前仍面临诸多独特挑战:混合交通环境下,全国 78% 的城市交叉口存在人车非混行冲突[1],且针对电动自行车/三轮车等中国特色交通工具的识别漏报率高达34%[2] ;高速公路因动态障碍物引发的二次事故占比达 41% ,较发达国家高出 15 个百分点[3];同时,在技术上仍存在“卡脖子”问题,包括高端激光雷达传感器进口依赖度超过 60% ,以及动态场景建模精度不足等共性算法缺陷[4]。

2.设计原理

2.1 模型架构优化

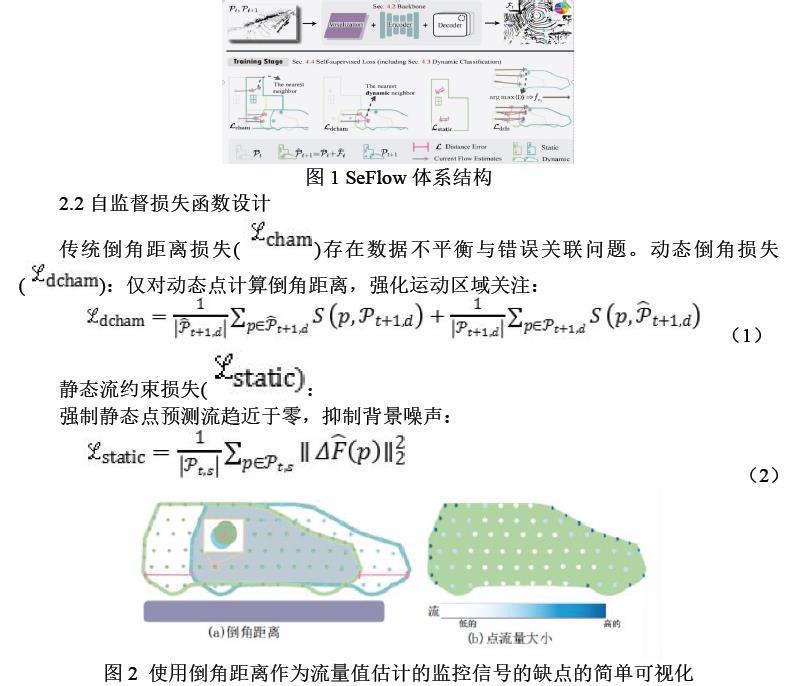

基于SeFlow的主干网络,通过融合GRU模块与迭代细化机制实现了效率与精度的有效平衡:该网络采用 0.2m 分辨率的体素化编码以保障大规模点云的实时处理能力[5];借助GRU时序建模模块维护隐藏状态,并通过门控机制实现动态信息更新;同时引入多粒度特征融合机制,将体素级特征与点级特征拼接以增强细节表达能力。最终,该架构在RTX 3090 环境下达到48ms/帧的推理速度,满足自动驾驶系统 10Hz的实时处理需求。SeFlow体系结构如图1 所示。

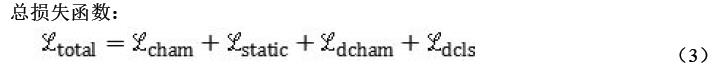

图2(a)说明了如何基于倒角距离计算损失,(b)中点上更密集 的颜色表示较高的流量值,白色表示点的流量为零。(b)表明,基于最近邻原理的流量结果可以导致物体中间的零流量估计。

2.3 数据高效性设计

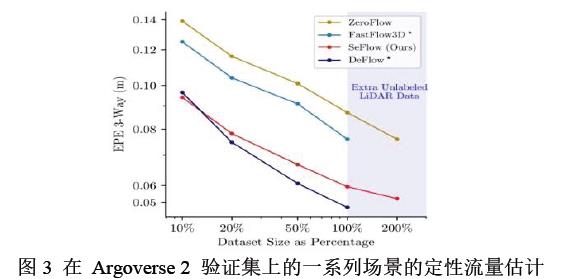

本方法通过动态感知指导训练,仅用 20% 数据即可超越ZeroFlow基线模型(使用100% 数据)。借助多损失协同优化机制,显著提升小物体与低速目标的流估计精度。在Argoverse 2 与Waymo数据集上,EPE 3-way误差降至 0.0628,优于ZeroFlow(0.0814),部分指标甚至优于监督方法;推理速度达48 毫秒/帧,比NSFP(32 秒/帧)快三个数量级,满足实时需求;鲁棒性增强,减少场景流碎片化。但对远距离稀疏点云目标的估计精度仍有待提高。未来可引入多模态融合和多帧时序建模,进一步提升性能。

3.结论

在推动绿色低碳交通方面,本文提出的SeFlow方法从多个维度提供了有效支持:首先,通过精准的 3D运动估计提升自动驾驶车辆的能源利用效率,使其能够合理规划路径并动态响应环境变化,减少急加速、急刹车等高能耗行为,从而降低燃油车碳排放与电动车的电能消耗;其次,作为底层感知技术,SeFlow有助于增强车路协同与交通流整体优化,可显著缓解道路拥堵,据中国智能交通协会研究,此类智能系统可实现城市交通碳减排 15%-20% ;此外,其自监督学习机制降低了对标注数据的依赖,减少了训练阶段的计算资源消耗,符合绿色计算的理念,其中流量估计结果如图 3 所示。综上所述,SeFlow不仅在技术性能上达到先进水平,也在推动可持续交通系统构建中展现出重要的应用潜力。

参考文献

[1]Zhang, Q., Yang, Y., Fang, H., Geng, R., Jensfelt, P.: DeFlow: Decoder of scene flow network in autonomous driving. In: 2024 IEEE International Conference on Robotics and Automation (ICRA). pp. 2105–2111 (2024)

[2]Vedder, K., Peri, N., Chodosh, N., Khatri, I., Eaton, E., Jayaraman, D., Ramanan, Y.L.D., Hays, J.: ZeroFlow: Fast Zero Label Scene Flow via Distillation. International Conference on Learning Representations (ICLR) (2024)

[3]Sun, P., Kretzschmar, H., Dotiwalla, X., Chouard, A., Patnaik, V., Tsui, P., Guo, J., Zhou, Y., Chai, Y., Caine, B., et al.: Scalability in perception for autonomous driving: Waymo open dataset. In: Proceedings of the IEEE/CVF conference on computer vision and pattern recognition. pp. 2446–2454 (2020)

[4]Duberg, D., Zhang, Q., Jia, M., Jensfelt, P.: DUFOMap: Efficient dynamic awareness mapping. IEEE Robotics and Automation Letters 9(6), 5038–5045 (2024)

[5]Li, X., Zheng, J., Ferroni, F., Pontes, J.K., Lucey, S.: Fast neural scene flow. In: Proceedings of the IEEE/CVF International Conference on Computer Vision. pp. 9878–9890 (2023)

.jpg)

.jpg)

.jpg)

.jpg)

.jpg)

.jpg)