基于服务器下发XML 文件解析的数据增量同步方案

王壮壮

中华人民共和国济南海关 山东 济南 250000

引言:随着企业数据规模的不断扩大和数据实时性要求的不断提高,传统基于全量数据导出的同步方式已无法满足业务需求。特别是在金融、电信等行业,需要处理大量实时交易数据,对数据同步的时效性和可靠性提出了更高要求。

1. 概述

1.1. 当前主流的数据同步方案主要存在以下问题:

(1) 需要从源数据库(如SqlServer)导出中间格式文件,增加了数据处理环节和延迟

(2) 全量同步方式资源消耗大,效率低下;

(3) 缺乏完善的异常处理机制,数据一致性难以保证。

本文提出的方案通过直接解析服务器下发的XML 数据流,实现了数据的增量同步

1.2. 方案的核心创新点包括:

(1) 基于递增编号的文件巡检机制;

(2) 高效稳定的XML 流式解析技术;

(3) 保障数据完整性的入库策略。

该方案已在某大型金融机构的生产环境中得到验证,显著提高了数据同步效率。

2. 相关技术

2.1. XML 解析技术

XML 作为一种通用的数据交换格式,在数据同步领域广泛应用。本方案采用SAX(Simple API for XML)解析器处理数据流,相比 DOM 解析器,SAX 具有内存占用小、解析速度快的优势,特别适合处理大体积XML 文件。

2.2. 数据同步策略

增量同步是数据集成领域的关键技术,本方案采用基于时间戳和递增编号的双重校验机制。服务器下发的 XML 文件按照递增编号组织,同步程序通过比较数据库中的最大索引和文件编号确定需要处理的增量数据。

2.3. 数据库事务管理

为保证数据同步的原子性和一致性,本方案利用 GBase 数据库的事务特性,将每个文件的数据处理封装为独立事务。同时采用幂等设计,确保异常情况下的重复处理不会导致数据不一致。

3. 方案设计

3.1. 系统架构

本方案的系统架构分为三个主要模块:

(1)文件监听模块:监控指定目录下的 XML 文件变化,根据递增编号识别新增文件。

(2)XML 解析模块:采用流式解析技术提取 XML 中的数据内容。

(3)数据加载模块:将解析后的数据按照预定义规则导入GBase 数据库

3.2. 增量同步流程同步流程的核心步骤如下:

(1)每 5 分钟触发一次巡检任务,查询数据库中当前最大索引值MAX_ID。(2)扫描文件目录,获取所有大于 MAX_ID 的文件列表。

(3)按编号顺序依次处理每个XML 文件。

(4)解析 XML 文件内容

(5)校验数据完整性

(6)执行数据导入操作

(7)更新数据库中的最大索引记录。

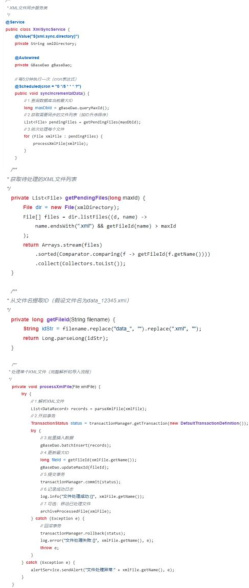

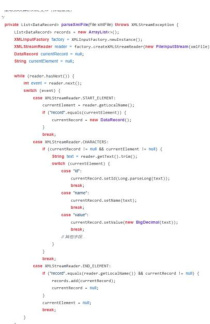

采用 Spring Scheduled 定时任务替代 while 循环,核心代码如下图所示:

3.3. 关键问题解决

3.3.1. 高效 XML 解析

采用基于事件驱动的 SAX 解析器,内存占用恒定,不受文件大小影响。针对特定业务场景优化解析规则,跳过无关数据节点,提高处理速度。

3.3.2. 数据完整性保障实施多层次的校验机制:

(1)文件级 MD5 校验;

(2)记录数比对;

(3)关键字段非空检查;

(4)数据类型验证。

3.3.3. 原子性与幂等性

通过数据库事务保证原子性,每个文件的处理要么全部成功,要么全部回滚。为实现幂等性,采用"INSERT ON DUPLICATE KEY UPDATE"语法,避免重复导入导致的主键冲突。

4. 实现与优化

4.1. 文件监听优化

采用 Java NIO 的 WatchService 机制监控目录变化,替代传统的定时全量扫描,降低系统开销。针对网络文件系统(NFS)的特殊情况,实现自定义的差异检测算法。

4.2. 解析性能提升通过以下措施优化解析性能:

(1)预编译 XPath 表达式;

(2)采用 StAX 解析器平衡性能与易用性;

(3)实现并行解析管道,充分利用多核 CPU。

4.3. 批量加载技术

使用 GBase 的批量加载接口,将单条INSERT 语句合并为批量操作。实测表明,批量大小设置为1000 时性能最优,较单条插入提升约20 倍。

5. 实验评估

5.1. 实验环境

服务器:Intel Xeon E5-2680 v4@2.40GHz,64GB RAM;

操作系统:CentOS 7.6;

数据库:GBase 8a V8.6;

测试数据:模拟生产环境的 XML 文件,平均大小50MB,包含约 10 万条记录。

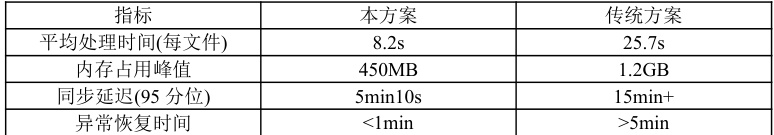

5.2. 性能指标

5.3. 可靠性测试

在连续 72 小时的稳定性测试中,处理了超过 10,000 个 XML 文件,无数据丢失或错误。模拟网络中断、磁盘满等异常场景,系统能够自动恢复并保证数据一致性。

6. 结论与展望

本文提出的基于服务器下发 XML 文件解析的数据增量同步方案,通过消除中间转换环节、优化解析流程和完善的事务管理,实现了高效可靠的数据同步。实际应用表明,该方案能够满足 5 分钟级别的实时性要求,大幅提升了数据集成效率。

未来工作将集中在以下方向:(1)支持更多数据格式如 JSON、Avro;(2)引入机器学习算法预测文件到达规律,优化资源分配;(3)实现跨数据中心的分布式同步方案。

参考文献:

[1] 张明,李强.XML 数据流的高效解析技术研究[J].计算机学报,2020,43(5):1021-103

5.

[2] Wang L,et al.Incremental Data Synchronization in Distributed Environments[C]

//ICDE 2019.

[3] GBase 8a 管理员手册.南大通用,2021.

[4] 刘伟.大数据环境下实时数据集成方案设计[D].清华大学,2022.

.jpg)

.jpg)

.jpg)

.jpg)

.jpg)

.jpg)